4月11日,阿里巴巴集团董事会主席兼CEO、阿里云智能集团CEO张勇表示,让计算成为公共服务是阿里云始终不变的追求,未来核心要做好两件事情:第一,让算力更普惠,推动自研技术和规模化经营的正循环,持续释放技术红利;第二,让AI更普及,让每家企业的产品都能接入大模型升级改造,并有能力打造自己的专属大模型。

张勇回顾阿里云的发展历程,过去十年阿里云自研核心技术,全面服务数字化进程。中国移动互联网的发展基本在阿里云上发生,企业从买计算机到按需购买算力就能开始创业,带来了巨大的效率提升。随后更多企业觉醒,各行各业在云上对全生产要素的数字化,形成了风起云涌的数字化时代。

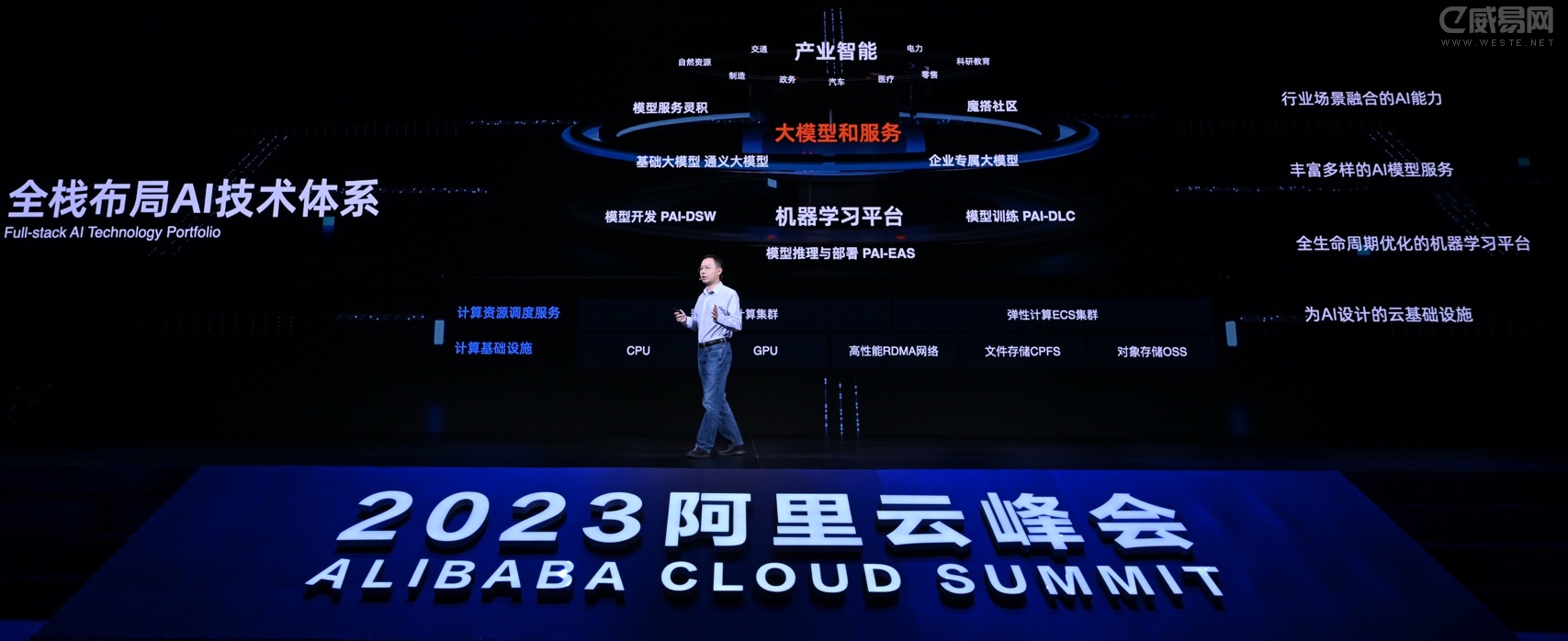

未来十年,阿里云将全面拥抱智能化时代。张勇表示,智能化时代带来算力的爆发,同时也提出了更高的要求,阿里云将为AI时代提供好算力基础和大模型能力,全面服务智能化进程。为此,阿里云要做好核心两件事:让算力更普惠、让AI更普及。

首先,阿里云将进一步降价,释放技术红利。阿里云通过软硬一体技术的研发,扩大自研CPU倚天710、云数据中心处理器CIPU、自研数据中心网络等核心技术应用,推动技术创新、规模化运营和成本降低的正循环,不断降低客户用云成本。

过去十年,阿里云提供的算力成本下降了80%,存储成本下降了近9成。今年,阿里云将推出一款更接近云计算终极形态的算力产品,这款被命名为通用Universal实例的产品进一步屏蔽了传统IT的硬件参数,让数据中心真正成为一台超级计算机,为中小企业和开发者提供普惠的算力。通用Universal实例的价格有大幅降低,对比上一代主售实例最高可下降40%。

大幅降价和开放核心产品的免费试用,将推动产业进一步从传统IT向云计算转移。目前,中国IT市场的云计算渗透率不到15%,中国数据中心的CPU利用率仅为10%左右。云计算可以大幅提升计算资源的利用率,云数据中心内的CPU平均利用率,可以达到传统数据中心的5倍以上。

其次,阿里云将推动AI进一步普及。张勇宣布,阿里巴巴所有产品未来将接入大模型,全面升级。他表示,要建设全新的AI开放生态,需要从阿里内部开始,目前,钉钉、天猫精灵已经在测试接入大模型,钉钉能实现自动写工作方案、生成应用等功能,天猫精灵接入通义千问后显著提升了智能化水平。

阿里云将面向企业提供更普惠的AI基础设施和大模型能力。据介绍,未来每一个企业都可以通过阿里云调用通义千问的全部能力,也可以结合企业自己的行业知识和应用场景,训练自己的企业大模型。比如,每个企业都可以有自己的智能客服、智能导购、智能语音助手、文案助手、AI设计师、自动驾驶模型等。

张勇表示,云计算是AI大规模普及的最佳方式,“未来,我们希望在阿里云上训练一个模型的成本,能够降低到现在的十分之一,甚至是百分之一。即使是中小企业,也能通过云平台获得AI大模型的能力和服务。”

阿里云推出三大举措

一、 用云门槛更低

推出ECS最新企业级U实例,比以往同类产品降价高达40%

为了让更多的企业特别是中小企业更加充分地享受云计算红利,阿里云推出新款通用算力型ECS云服务器Universal实例(简称U实例)。U实例整合了多种云服务器规格,无需进行复杂的资源配置,售价相比上一代主售实例降幅最高可达40%,更适合Web应用及网站、企业办公类应用、离线数据分析、中小型数据库等典型应用场景,具备与其他同类产品一致的稳定性和用户体验。同时,阿里云还推出了“0元升配”活动,使用5/6代实例的用户可免费升级至第7代ECS实例。

U实例规格最小2vCPU、 最大32vCPU,每一个vCPU都对应一个处理器核心的超线程,实例间无CPU资源争抢,拥有企业级实例的性能和稳定性,极大地降低了中小企业用户的选型门槛。

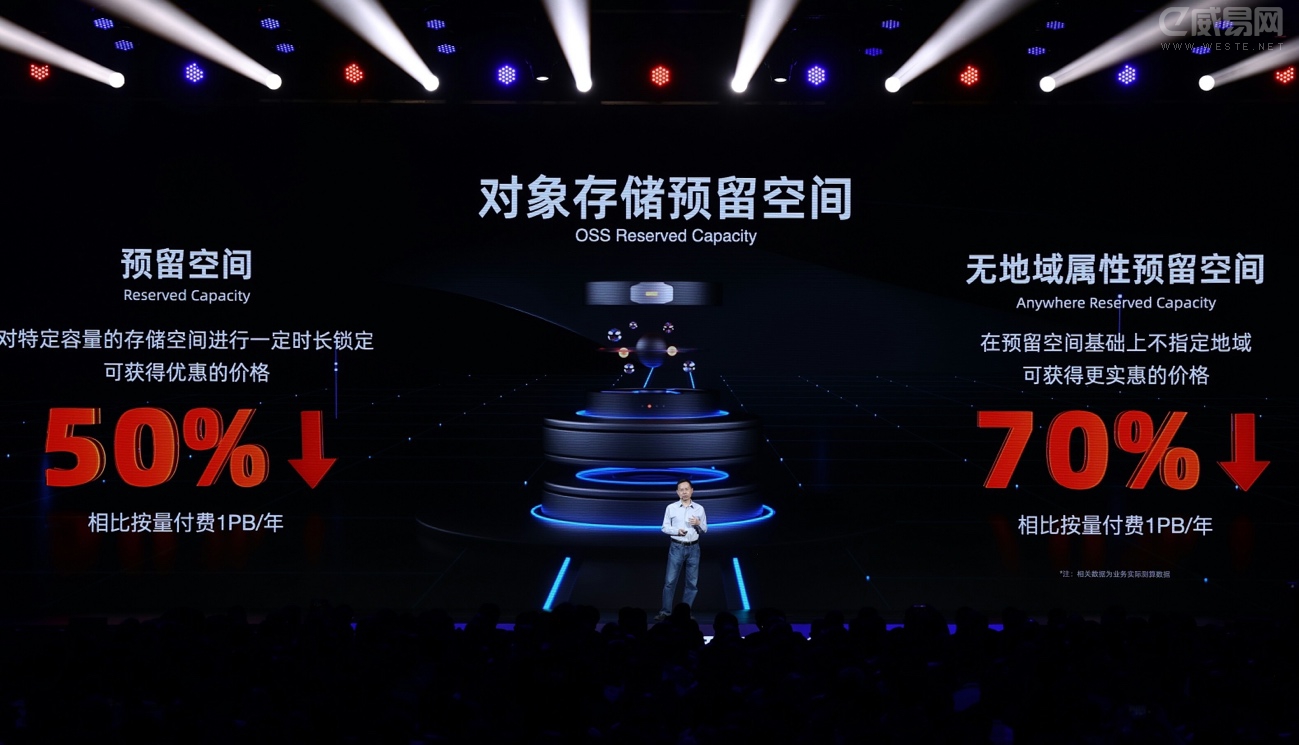

对象存储预留空间产品:最高降价70%

用户还可通过预留云上存储空间和锁定购买时长,来获得更低的长期存储成本。新发布的对象存储预留空间产品OSS-RC,用户购买1TB/年、1PB/年的存储费用相比按量付费分别下降量36%和50%;若选择无地域属性预留空间,10TB/年、1PB/年的存储费用分别可下降64%和70%,更适用于互联网音视频、云相册、数据备份等多种业务场景下的数据存储与管理。

持续释放规模和技术红利

对主售产品实行大幅降价,得益于阿里云对软硬一体技术整合的大力投入,提高计算资源利用率,带动算力成本不断降低,从而推动规模扩大和价格降的正循环。基于飞天云操作系统和云基础设施处理器CIPU,从最底层的核心部件到最上层云原生软件,阿里云构建了完整的自研技术体系。将虚拟化消耗降至0并加速数据传输,同时进一步扩大硬件资源的灵活调度。在倚天+飞天+CIPU的组合下,数据库、大数据和AI及高性能计算、视频编解码等场景下普遍优于业内同类产品,性能可提升20%以上。

加速击穿云计算向传统IT渗透的拐点

云计算能带来极大的算力资源节约,目前,国内数据中心的CPU平均利用率在10%左右,而云数据中心内的CPU平均利用率,可以达到传统数据中心的5到10倍。阿里云对主售产品价格的大幅调低,将会促进云计算渗透率进一步提升,更好地满足智能化时代对的算力需求。

帮助用户降本增效

阿里云提供的CloudOps工具集,全面助力用户提升云上DevOps的效率和稳定性。CloudOps等于Cloud乘以Ops,它意味着将云天然具备的弹性能力、高可用能力、标准化的自动化能力通过标准的API方式直接赋能给用户。

弹性伸缩:通过弹性伸缩服务,企业客户的开发运维人员能自助完成应用的自动化弹性;

资源编排:通过资源编排自助实现应用基础设施的一键部署;

运维编排:通过运维编排自助完成新版本的蓝绿发布或金丝雀发布;

诊断工具:通过ECS诊断工具快速定位问题,大大缩短应用从开发到上线的交付周期,提升企业价值交付效率。

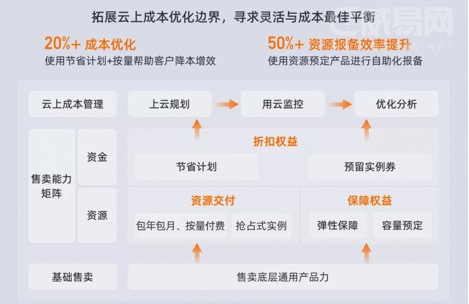

此外,阿里云结合客户实例总结出了一套云上持续成本优化方法,针对客户的资源开通、成本优化和资源锁定三方面的购买诉求,阿里云提供了灵活多样的付费模式,包括资源交付类、折扣权益类和保障权益类。其中,节省计划与按量付费的结合可以帮助客户实现20%的成本优化,使用资源预定产品进行自助化报备,资源报备效率提升50以上。

云计算按量付费、多样付费的选择为企业客户构筑了最优的弹性体验,也让客户在使用阿里云产品的同时得到了最高的效率提升和成本优化,灵活多样的弹性计算服务模式也为客户提供了全场景的资源成本保障。

数字化时代,无数“数字原生企业”长在云计算平台上;随着AIGC带来的智能化浪潮,AI也会在云计算平台上实现大规模普及。云计算平台可提供超大规模智能算力、机器学习平台、丰富的开源模型和便捷的API接口,让企业的AI训练和推理更便捷:

高性能融合算力:采用自研的高性能Solar-RDMA网络协议和稳定低时延的新一代高速网络拥塞控制HPCC算法,灵骏智算可以实现800G全速无拥塞RDMA网络,网络通信时延低至2微秒。在此基础之上,灵骏可支持最大十万卡GPU的单集群规模,可以承载多个万亿参数规模的大模型同时在线训练。高效能的存储使得数据读取不会有瓶颈,灵骏采用高性能文件存储产品,全集群超高并行存储吞吐可达20TB每秒,并有自研数据加载优化技术,同过打通深度学习框架、调度系统和存储系统,实现了针对深度学习任务的高效数据缓存。对于快速发展的AIGC等领域,极致优化的加速比可以显著缩短客户训练模型的时间,灵骏智算通过自研的集合通信优化库,专门针对AI大模型训练的通信模式进行优化,性能线性加速比可提升17%。

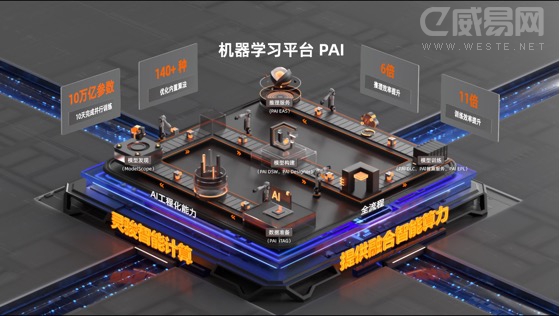

机器学习平台PAI:在高性能网络集群的基础上,阿里巴巴构建了PAI-灵骏产品来提供大数据加AI一体化平台,从而能够高效推动算法的开发迭代,支撑超大规模模型训练任务,为大模型的产生提供系统支持。用户可以用PAI-DSW提供的notebook进行模型代码的开发,并且进行小规格的验证,然后再把大规模训练任务提交到PAI-DLC云原生训练平台,从而能够快速利用海量的弹性的云上算力资源来加速训练。深度神经网络模型往往有复杂、细粒度的数据依赖,难以并行,PAI通过一系列编译优化技术,不仅可以自动并行,还可以动态平衡通讯代价、内存消耗和计算并行度等多个资源维度,实现模型在大规模异构集群的最优分布式执行。这些能力也让算法开发者能够聚焦在模型本身,通过技术手段让训练能够更加高效,并且能够适用多种异构的算力资源。通过这些技术积累,阿里巴巴PAI平台能够训练10万亿规模的模型,能够支持万卡的单任务分布式训练规模,分布式加速比接近线性,能够有92%线性扩展效率,在一些训练场景上能够带来10x训练效率提升。

Model as a Service:去年11月,阿里在国内首提“Model as a Service”理念,牵头推出的“魔搭”已成为国内规模最大的AI模型社区,总用户量达106万,模型总下载量超1628万。魔搭社区已与17家顶尖人工智能机构合作,以开源的方式提供多类优质模型,供开发者免费体验与下载使用。ModelScope提供:

覆盖自然语言、图像、语音等多领域的具有竞争力的SOTA模型,以及阿里云智能自研的、行业领先的多模态大模型,全部免费开放下载以及使用。当前模型总数突破1500个,其中生态贡献900个,数量上超过阿里提供的600个模型。

提供本地推理接口以及线上模型推理预测服务,仅需一行代码就可以使用模型推理能力,方便开发者快速验证与使用;仅需十几行代码实现对预训练模型的finetune,方便开发者基于行业数据集快速构建行业专属模型。

开发者可以一键开启在线Notebook实训平台,兼容主流AI框架,更好地实现模型迁移,链接澎湃云端算力,支持多种模型训练与服务部署方式,提供更多自主可控的选择。

三、让开发者更强大

面向开发者发布“飞天免费试用计划”,宣布全栈云产品开放免费体验,50多款产品免费试用时长最多可达3个月。

飞天免费试用计划:除了帮助用户优化成本外,阿里云还向开发者们抛出橄榄枝,推出“飞天免费试用计划”,面向国内1000万云上开发者,提供包括ECS、数据库PolarDB、机器学习PAI等在内50 款云产品的免费试用,时长支持1个月、3个月到长期免费,可支持开发者构建包括在线、大数据类、AI等不同类型应用,并且支持serverless的开发模式。 同时还提供完备的产品文档、一键部署的技术解决方案、1000多门免费课程,让开发者“零门槛”体验云服务。

阿里云正在推进核心产品全面Serverless化,用户无需关心和管理底层IT资源,以更接近“电网”模式,按计算的调用次数付费。组装式开发可以进一步降低云计算开发门槛,让技术成为生产力工具,开发工具更易用,让非技术人员也可以参与到开发中。

以南瓜电影为例,在其APP采用Serverless后,不仅无人值守即可应对百万级流量,而且总成本较之前下降40%。

以高德地图为例:得益于 Serverless 的零运维特性,客户端开发人员可独立开发和发布卡片、气泡等精准服务,使用函数计算实现多变的业务逻辑。这些后端服务又能沉淀为可复用业务模块,支持独立迭代,风险大幅降低。目前,高德采用组装式开发模式构建的新平台已承载 100% 的生产流量,业务规模达到百万 QPS。功能交付时间从天缩短至小时,整体成本降低了 38%。

阿里云数据库PolarDB、AnalyticDB、RDS、Lindorm等核心产品全面Serverless化后,均实现性价比提升。例如,RDS基于自研CPU的软硬协同优化,整体性价比提升25%;PolarDB通过融合自研Smart-SSD智能固态硬盘技术,实现性能零损耗,数据存储成本最高下降60%。

基于这套体系,阿里云能为用户带来稳定、安全、性能等全方位的提升,并采用规模化部署为用户降低用云成本。以阿里巴巴为例,整体上云后,每万笔峰值交易的IT成本下降了80%。